چطور یک سیستم RAG برای چت بات سازمانی بسازیم (با مثال عملی)

مقدمه: فراتر از محدودیتهای مدلهای زبانی بزرگ

مدلهای زبانی بزرگ (LLM) با قابلیتهای شگفتانگیز خود در تولید متن، درک زبان طبیعی و پاسخگویی به طیف وسیعی از پرسشها، صنعت هوش مصنوعی را متحول کردهاند. با این حال، در کاربردهای سازمانی، این مدلها با محدودیتهای ذاتی مواجه هستند. دانش آنها به دادههایی که در زمان آموزش دیدهاند، محدود میشود و قادر به دسترسی به اطلاعات بهروز، محرمانه یا اختصاصی سازمان نیستند. این عدم دسترسی به دادههای جدید، به ویژه در حوزههایی مانند پزشکی، مالی یا حقوقی که اطلاعات به سرعت تغییر میکند، منجر به پاسخهای منسوخ، نادرست و حتی پدیده “توهمزایی” (Hallucination) میشود. در این پدیده، مدل با اطمینان کامل، اطلاعات نادرست یا ساختگی ارائه میکند که میتواند در محیطهای حساس سازمانی، ریسکهای جدی ایجاد کند.

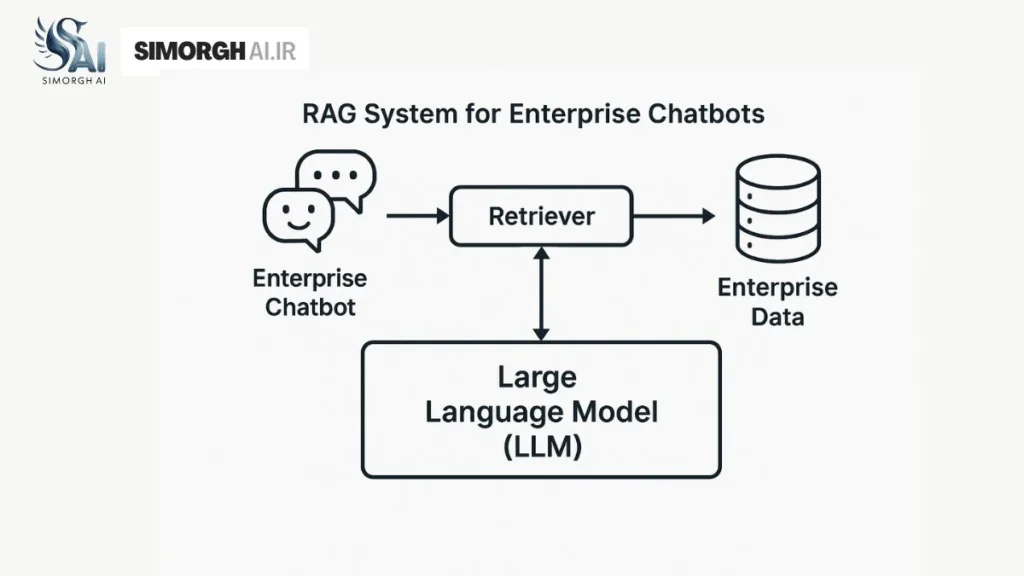

برای غلبه بر این چالشها، یک چارچوب هوش مصنوعی جدید به نام Retrieval-Augmented Generation (RAG) به وجود آمده است. RAG با بازیابی اطلاعات مرتبط از یک پایگاه دانش خارجی و معتبر، پاسخهای مدلهای زبانی بزرگ را تقویت میکند. این رویکرد به مدل اجازه میدهد تا از دانش خارج از دادههای آموزشی خود بهره ببرد و پاسخهایی دقیقتر، مرتبطتر و قابل اتکاتر ارائه دهد. RAG نهتنها قابلیت اطمینان مدل را افزایش میدهد، بلکه به کاربران امکان میدهد تا منابع اطلاعاتی مورد استفاده را بررسی و صحت ادعاهای مدل را تأیید کنند، که این خود به تقویت اعتماد کاربران منجر میشود.

این چارچوب، یک تغییر پارادایم اساسی را در نحوه استفاده از LLMها در سازمانها رقم میزند. مدلهای سنتی هوش مصنوعی، دانش را در پارامترهای خود ذخیره میکنند و هرگونه بهروزرسانی یا افزودن اطلاعات جدید، نیازمند فرآیندی پرهزینه و زمانبر است که شامل بازآموزی (Retraining) یا تنظیم دقیق (Fine-Tuning) میشود. در مقابل، RAG دانش را از مدل جدا کرده و آن را در یک پایگاه داده خارجی ذخیره میکند. این پایگاه دانش، که میتواند شامل اسناد داخلی، پایگاههای داده یا دادههای بهروز باشد، به صورت مستقل و با سرعت بالا قابل بهروزرسانی است. این رویکرد، انعطافپذیری سیستم را به شدت افزایش میدهد و هزینههای محاسباتی مربوط به آموزش مجدد مدل را حذف میکند. با این حال، باید توجه داشت که RAG نیز تضمینکننده حذف کامل توهمزایی نیست و احتمال ارائه پاسخهای نادرست همچنان وجود دارد.

مبانی معماری RAG: اجزا، عملکرد و چرخه حیات

یک سیستم RAG در هسته خود بر یک فرآیند دو مرحلهای استوار است که با نام “چرخه حیات RAG” شناخته میشود. این فرآیند، اطلاعات را از منابع خارجی بازیابی کرده و برای تولید پاسخی جامع و دقیق به کاربر مورد استفاده قرار میدهد.

فاز اول: نمایهسازی (Indexing)

این فاز شامل آمادهسازی دادههای منبع برای بازیابی سریع و کارآمد است.

- بارگذاری (Load): در ابتدا، دادههای خام از منابع مختلف سازمانی مانند فایلهای متنی، PDF، وبسایتها، پایگاههای داده و APIها جمعآوری میشوند. فریمورکهایی مانند LangChain و LlamaIndex صدها ابزار بارگذار اسناد (Document Loaders) را برای این منظور ارائه میدهند.

- قطعهبندی (Split/Chunking): اسناد بزرگ به قطعات (chunks) کوچکتر و قابل مدیریت تقسیم میشوند. این مرحله حیاتی است، زیرا قطعات بزرگتر، جستجو را دشوار میکنند و در پنجره زمینه (Context Window) محدود مدلهای زبانی بزرگ جا نمیشوند. انتخاب استراتژی قطعهبندی (مانند بر اساس پاراگراف یا هدر) و اندازه قطعه (Chunk Size) بر عملکرد نهایی سیستم تأثیر بسزایی دارد.

- ذخیرهسازی و نمایهسازی (Store/Index): هر قطعه متن با استفاده از یک مدل Embedding به یک بردار عددی (Vector) تبدیل میشود. این بردارها، که معنای مفهومی متن را در یک فضای چندبعدی نشان میدهند، سپس در یک پایگاه داده برداری (Vector Database) ذخیره و نمایهسازی میشوند. این پایگاههای داده، به جستجوی معنایی کارآمد (Semantic Search) بر اساس نزدیکی بردارها به جای جستجوی کلمات کلیدی سنتی کمک میکنند.

فاز دوم: بازیابی و تولید (Retrieval & Generation)

این فاز در زمان دریافت درخواست کاربر به صورت بلادرنگ اجرا میشود.

- بازیابی (Retrieve): با دریافت درخواست کاربر، سیستم آن را با استفاده از همان مدل Embedding به یک بردار تبدیل میکند. سپس از طریق یک Retriever، مرتبطترین بردارهای ذخیرهشده در پایگاه داده برداری را پیدا و قطعات متنی متناظر با آنها را بازیابی میکند.

- تولید (Generate): قطعات بازیابیشده به عنوان “زمینه” به همراه درخواست اصلی کاربر به یک مدل زبانی بزرگ (LLM) ارسال میشوند. مدل سپس از این زمینه برای تولید پاسخی دقیق و مرتبط به درخواست کاربر استفاده میکند.

عملکرد یک سیستم RAG، به شدت به کیفیت دادهها و فرآیندهای اولیه بستگی دارد. اگر فرآیند قطعهبندی به درستی انجام نشود، برای مثال جملات مرتبط از هم جدا شوند، یا مدل Embedding انتخابی برای دامنه تخصصی سازمان (مانند حقوق یا پزشکی) مناسب نباشد، فرآیند بازیابی از پایه دچار نقص خواهد شد. این نقص در بازیابی، حتی با یک مدل تولید (Generator) قدرتمند، به تولید پاسخهای نادرست یا نامرتبط منجر میشود. این امر، بر اهمیت حاکمیت داده (Data Governance) در طول فاز نمایهسازی تأکید میکند، چرا که یک سیستم RAG با دادههای ضعیف، میتواند حتی از یک LLM بدون RAG نیز عملکرد بدتری داشته باشد.

اجزای کلیدی معماری RAG

- پایگاههای داده برداری (Vector Databases): این پایگاهها ستون فقرات یک سیستم RAG هستند. آنها برای ذخیره و جستجوی بردارهای با ابعاد بالا بهینهسازی شدهاند و جستجوی معنایی را به جای تطابق دقیق کلمات، امکانپذیر میسازند. این قابلیت برای پیدا کردن اطلاعات مرتبط، حتی زمانی که کلمات کلیدی دقیقاً یکسان نیستند، حیاتی است.

| ویژگی | Chroma | Pinecone | Milvus |

| رویکرد اصلی | پایگاه داده برداری متنباز، بومی پایتون، سبکوزن | سرویس ابری کاملاً مدیریتشده | پایگاه داده برداری توزیعشده متنباز |

| کاربرد ایدهآل | توسعه سریع و نمونهسازی، پروژههای کوچک و متوسط، محیطهای محلی | مقیاس سازمانی، بارهای کاری با توان عملیاتی بالا، محیطهای تولیدی | بارهای کاری تولیدی توزیعشده با توان عملیاتی بالا و مقیاسپذیری |

| مزایای کلیدی | نصب آسان با pip، بومی پایتون، تجربه توسعهدهنده بهینه، بدون نیاز به طرحواره اجباری | مدیریتشده کامل، مقیاسپذیری افقی، بهینهسازی برای عملکرد و latency پایین | بهینهسازی برای جستجوی شباهت در مقیاس بزرگ، انعطافپذیری |

| معایب کلیدی | ممکن است در مقیاسهای بسیار بزرگ به اندازه سرویسهای ابری قدرتمند نباشد | هزینه بالاتر، اتکا به سرویس ابری، کنترل کمتر بر زیرساخت | پیچیدگی بیشتر در راهاندازی و مدیریت نسبت به گزینههای سبکوزن |

- مدلهای Embedding: این مدلها مسئول تبدیل متن به بردارهای عددی هستند که معنای مفهومی را در خود جای میدهند. انتخاب یک مدل Embedding مناسب برای حوزه و زبان خاص سازمان، بر دقت و ارتباط نتایج بازیابی شده تأثیر مستقیم دارد.

| مدل | اندازه مدل | ویژگیهای کلیدی | کاربرد پیشنهادی |

intfloat/e5-large-v2 | بزرگ | طراحیشده برای تولید Embedding کارآمد | وظایف پردازش زبان طبیعی عمومی |

Salesforce/SFR-Embedding-2_R | نامشخص | تقویتکننده بازیابی متن و جستجوی معنایی | کاربردهای نیازمند دقت بالا در بازیابی |

Alibaba-NLP/gte-Qwen2-7B-instruct | ۷ میلیارد پارامتر | عملکرد بالا برای وظایف پیچیده Embedding | وظایف Embedding پیچیده |

intfloat/multilingual-e5-large-instruct | ۰.۵ میلیارد پارامتر | چندزبانه، پشتیبانی از زبانهای مختلف | کاربردهای چندزبانه و بینالمللی |

jinaai/jina-embeddings-v2-base-en | ۰.۱ میلیارد پارامتر | بهینهسازیشده برای متن انگلیسی | کاربردهای مرتبط با متن انگلیسی |

jinaai/jina-embeddings-v2-base-code | ۰.۱ میلیارد پارامتر | بهینهسازیشده برای کد | کاربردهای مرتبط با کدنویسی |

پیادهسازی عملی RAG: فریمورکها و مثالهای کد

پیادهسازی یک سیستم RAG در عمل، نیازمند هماهنگی چندین جزء مختلف است. خوشبختانه، فریمورکهای متعددی این فرآیند را سادهسازی کردهاند.

انتخاب فریمورک مناسب

دو فریمورک برجسته در اکوسیستم RAG، LangChain و LlamaIndex هستند.

| ویژگی | LangChain | LlamaIndex |

| رویکرد اصلی | پلتفرم ماژولار و همهکاره برای ساخت «زنجیرهها» و «عوامل» (Agents) | پلتفرم متمرکز بر نمایهسازی، جذب داده و بازیابی اطلاعات |

| سهولت استفاده | دارای منحنی یادگیری تندتر، نیازمند درک عمیقتر از مفاهیم LLM | دارای منحنی یادگیری ملایمتر، API سطح بالا و کاربرپسند |

| انعطافپذیری | بسیار منعطف، اجازه ترکیب مدلها، ابزارها و زنجیرهها را میدهد | در رویکرد خود مقیدتر است و سهولت استفاده را بر کنترل دقیق ارجحیت میدهد |

| قابلیتهای نمایهسازی | پشتیبانی از بارگذارهای داده متنوع و اجازه ساخت پایپلاینهای دلخواه | در این زمینه قوی است، با استراتژیهای نمایهسازی متعدد و دسترسی به صدها دیتا لودر از طریق LlamaHub |

| قابلیتهای جستجو | بلوکهای ساختاری انعطافپذیر را فراهم میکند اما پیادهسازی الگوهای جستجوی پیشرفته نیازمند پیکربندی دستی بیشتری است | بهینهسازیشده برای جستجوهای پیشرفته، پشتیبانی از زیرپرسشها (subqueries) و خلاصهسازی چندسندی |

| موارد استفاده | ساخت برنامههای پیچیده، سیستمهای استدلال چندمرحلهای و تعامل با سرویسهای خارجی | برنامههای RAG ساده و روان، سیستمهای مدیریت دانش و مرجع داخلی |

LlamaIndex برای ورکفلوهای ساده و متمرکز بر جستجو و بازیابی ایدهآل است، در حالی که LangChain یک پلتفرم ماژولار و انعطافپذیرتر برای ساخت «زنجیرهها» و «عوامل» پیچیدهتر است.

مثال عملی پیادهسازی با پایتون

پیادهسازی RAG یک فرآیند صرفاً کدنویسی نیست؛ بلکه یک پروژه مهندسی سیستمهای توزیعشده است که نیازمند هماهنگی ابزارهای مختلفی است. این فرآیند شامل مراحل زیر است:

- آمادهسازی محیط: نصب کتابخانههای ضروری مانند

langchain-community,langchain-openai,langchain-text-splitters, وqdrant_client. - بارگذاری و قطعهبندی داده: اسناد، بارگذاری و به قطعات کوچک تقسیم میشوند. برای مثال، میتوان از

RecursiveCharacterTextSplitterدر LangChain برای این منظور استفاده کرد. - نمایهسازی و ذخیرهسازی: قطعات متنی به بردارهای عددی تبدیل و در یک پایگاه داده برداری مانند ChromaDB یا Qdrant ذخیره میشوند.

- ساخت زنجیره RAG: در این مرحله، اجزا به یکدیگر متصل میشوند. یک

PromptTemplateبرای هدایت LLM تعریف میشود تا پاسخها را بر اساس زمینه بازیابیشده تولید کند. سپس،RetrieverوLLMبا استفاده ازRunnablePassthroughدر LangChain به یکدیگر زنجیر میشوند.

این فرآیند نشان میدهد که موفقیت در پیادهسازی RAG مستلزم دانش کافی از اکوسیستم ابزار است و صرفاً به یک کدنویسی ساده محدود نمیشود.

تکنیکهای پیشرفته RAG برای کاربردهای سازمانی

در حالی که معماری RAG ساده برای پرسشهای مستقیم و متداول (FAQ) کارآمد است، در محیطهای سازمانی با پرسشهای پیچیده و چندمرحلهای، با محدودیتهایی مانند دقت پایین در بازیابی مواجه میشود. برای حل این مشکلات، تکنیکهای پیشرفتهای توسعه یافتهاند.

بهبود مرحله بازیابی

- رتبهبندی مجدد (Reranking): پس از بازیابی اولیه اسناد مرتبط، یک مدل جداگانه به نام Reranker، آنها را مجدداً بر اساس ارتباط با زمینه کلی پرسش رتبهبندی میکند. این فرآیند، دقت بازیابی را به شدت افزایش میدهد و اطمینان میدهد که مرتبطترین اطلاعات به LLM ارسال میشوند.

- جستجوی ترکیبی (Hybrid Search): این تکنیک، جستجوی معنایی (بر اساس بردارهای معنایی) را با جستجوی کلمات کلیدی (مانند BM25 یا TF-IDF) ترکیب میکند. این رویکرد تعادلی بین دقت و فراخوانی (Recall) ایجاد میکند و احتمال پیدا کردن هم اسناد حاوی کلمات کلیدی دقیق و هم اسناد مرتبط مفهومی را افزایش میدهد.

معماریهای پیچیده RAG

- Branched RAG: این تکنیک برای مدیریت پرسشهای پیچیده و چندبعدی طراحی شده است. Branched RAG یک پرسش را به چندین زیرسوال (Sub-questions) تجزیه میکند، برای هر کدام به صورت جداگانه دادهها را بازیابی و در نهایت پاسخهای به دست آمده را برای ارائه یک پاسخ جامع ترکیب میکند.

- Agentic RAG: در مقابل RAG سنتی که یک فرآیند خطی “بازیابی-تولید” است، Agentic RAG پویاتر عمل میکند. در این معماری، یک عامل (Agent) هوشمندانه فرآیند بازیابی اطلاعات را مدیریت میکند. این عامل توانایی تصمیمگیری و استدلال دارد، میتواند ابزارهای مختلف را فراخوانی کند و به صورت فعالانه اطلاعات را برای رسیدن به یک هدف مشخص، بازیابی میکند.

این تکنیکهای پیشرفته مستقیماً برای حل پیچیدگیهای دنیای واقعی در محیطهای سازمانی طراحی شدهاند. به عنوان مثال، یک پرسش مانند “اثر یادگیری ماشین بر روی دو حوزه بهداشت و درمان و مالی چیست؟” برای RAG ساده یک چالش است، اما Branched RAG با تجزیه آن به دو زیرسوال، میتواند پاسخهایی دقیق و مجزا برای هر حوزه بازیابی کند. این نشان میدهد که RAG یک فناوری ثابت نیست، بلکه یک زمینه در حال تکامل است که با افزایش پیچیدگی نیازهای سازمانی، تکامل مییابد.

RAG در برابر Fine-Tuning: تحلیل راهبردی و رویکرد ترکیبی

RAG و Fine-Tuning دو روش کلیدی برای افزایش ارزش مدلهای زبانی بزرگ در کاربردهای سازمانی هستند. در حالی که هر دو هدف مشابهی را دنبال میکنند، رویکردهای آنها به طور قابل توجهی متفاوت است.

| معیار | Retrieval-Augmented Generation (RAG) | Fine-Tuning (تنظیم دقیق) |

| هدف اصلی | تزریق دانش جدید، بهروز و اختصاصی در زمان واقعی | تغییر رفتار، لحن یا سبک مدل و آموزش در یک حوزه تخصصی |

| نحوه عملکرد | بازیابی اطلاعات مرتبط از یک پایگاه دانش خارجی و استفاده از آن به عنوان زمینه (Context) برای مدل | بهروزرسانی وزنهای مدل پایه با استفاده از یک مجموعه داده تخصصی و دارای برچسب |

| هزینه و زمان | پیادهسازی اولیه ارزانتر و سریعتر | نیازمند منابع محاسباتی و زمان بیشتر برای آموزش اولیه |

| بهروزرسانی دادهها | قابلیت بهروزرسانی لحظهای پایگاه دانش | نیازمند بازآموزی دورهای مدل برای بهروز ماندن |

| امنیت و حریم خصوصی | دادههای حساس در یک پایگاه داده امن محلی باقی میمانند | دادههای آموزشی در مدل جاسازی میشوند که میتواند ریسک امنیتی ایجاد کند |

| مهارتهای فنی | نیازمند مهارتهای مهندسی داده و سیستم | نیازمند تخصص عمیق در یادگیری عمیق و پردازش زبان طبیعی |

| کاربرد در صنایع | پاسخ به پرسشهای مرتبط با دادههای بهروز (مثلاً پشتیبانی مشتری) | ایجاد یک مدل متخصص در یک حوزه با اصطلاحات خاص (مثلاً پزشکی یا حقوقی) |

این مقایسه نشان میدهد که تصمیمگیری بین RAG و Fine-Tuning یک انتخاب صرفاً فنی نیست؛ بلکه یک تصمیم راهبردی است که به نیازهای تجاری، بودجه، مهارتهای تیم، اهمیت حریم خصوصی دادهها و سرعت تغییر اطلاعات در سازمان بستگی دارد.

با این حال، این دو رویکرد لزوماً متضاد نیستند، بلکه مکمل یکدیگرند. در یک رویکرد ترکیبی (Hybrid Approach)، میتوان از هر دو روش برای دستیابی به بهترین نتیجه استفاده کرد. در این مدل، Fine-Tuning به مدل اجازه میدهد تا “شخصیت” و “سبک” خاصی را یاد بگیرد، مانند لحن یک متخصص مالی یا پزشکی. سپس، RAG به این مدل متخصص، “دانش” بهروز و دقیق میدهد تا پاسخهایش همیشه بر اساس آخرین اطلاعات باشد. این ترکیب، به ایجاد یک “متخصص دیجیتال” واقعی منجر میشود که هم درک عمیقی از حوزه دارد و هم به آخرین اطلاعات دسترسی دارد.

چالشها و بهترین روشها برای سیستمهای RAG در مقیاس سازمانی

پیادهسازی یک سیستم RAG در مقیاس سازمانی، فراتر از یک اثبات مفهوم (PoC) ساده است و با چالشهای فنی و حاکمیتی متعددی همراه است.

چالشهای فنی

- تأخیر (Latency): فرآیند بازیابی اطلاعات و سپس ارسال آن به مدل برای تولید پاسخ، میتواند تأخیر قابل توجهی در پاسخدهی سیستم ایجاد کند، به ویژه در کوئریهای پیچیده.

- مقیاسپذیری (Scalability): با افزایش حجم دادهها به میلیونها سند، نمایهسازی و جستجو در پایگاه داده برداری به چالش کشیده میشود.

- دقت بازیابی (Retrieval Accuracy): حتی با وجود دادههای مرتبط، ممکن است سیستم قطعات نامرتبط یا ناکافی را بازیابی کند، که این امر منجر به پاسخهای ضعیف میشود.

چالشهای حاکمیتی و امنیتی

- افشای دادهها: RAG با تبدیل اسناد محرمانه به بردارهای عددی، ممکن است ریسک افشای دادهها را از طریق نشت این بردارهای حساس ایجاد کند.

- کنترل دسترسی: سیستمهای RAG اغلب با مجوزهای گسترده کار میکنند و کنترل دسترسی دقیق بر روی زیرمجموعههای مختلف دادهها ندارند. این امر با اصل حداقل امتیاز (Principle of Least Privilege) در سازمانها در تضاد است.

- حاکمیت داده (Data Governance): بدون یک چارچوب حاکمیتی قوی، سیستم RAG با خطر استفاده از دادههای نادرست، منسوخ یا غیرقابل اعتماد مواجه است.

| چالش | راهکار |

| تأخیر | پیادهسازی Caching در سطح Retriever و Prompt برای ذخیره نتایج جستجوهای قبلی ؛ استفاده از پایگاههای داده برداری توزیعشده و پردازش موازی |

| مقیاسپذیری | طراحی معماری ماژولار و مبتنی بر کامپوننت ؛ استفاده از پایگاههای داده برداری توزیعشده مانند Pinecone یا Qdrant |

| دقت بازیابی | استفاده از تکنیکهای پیشرفته مانند Reranking و Query Decomposition ؛ بهبود استراتژیهای قطعهبندی بر اساس نوع سند |

| امنیت | پیادهسازی کنترل دسترسی مبتنی بر نقش (RBAC) ؛ رمزنگاری دادهها در حال سکون و انتقال ؛ استفاده از سیستمهای ممیزی (Auditing) جامع برای ردیابی فعالیتها |

| حاکمیت داده | تعریف سیاستهای مشخص برای کیفیت دادهها و بهروزرسانی آنها ؛ ردیابی منشأ دادهها ؛ تشکیل کمیتههای حکمرانی هوش مصنوعی |

این تحلیل نشان میدهد که پیادهسازی RAG در مقیاس سازمانی، یک مشکل صرفاً فنی نیست، بلکه یک چالش فنی-سازمانی است. موفقیت یک پروژه RAG به همکاری تیمهای بینرشتهای، از جمله مهندسان نرمافزار، دانشمندان داده، مسئولان حاکمیت داده و کارشناسان حقوقی و امنیتی بستگی دارد.

مطالعات موردی و کاربردهای عملی در صنایع مختلف

سیستم RAG در صنایع مختلفی برای بهبود کارایی و دقت در حال استفاده است.

- پشتیبانی مشتری (DoorDash): شرکت DoorDash از یک چتبات مبتنی بر RAG برای پشتیبانی از پیکهای خود استفاده میکند. این سیستم با خلاصه کردن مکالمه، مقالات مرتبط و پروندههای حلشده قبلی را از یک پایگاه دانش بازیابی میکند. برای تضمین کیفیت، از ابزاری به نام LLM Guardrail برای نظارت بر دقت پاسخها و از LLM Judge برای ارزیابی عملکرد سیستم در طول زمان استفاده میکند.

- مدیریت دانش سازمانی (LinkedIn & Bell): لینکدین از RAG و Knowledge Graph برای بهبود سیستم پاسخگویی به سوالات پشتیبانی فنی استفاده کرده است. این رویکرد زمان حل مشکل را تا ۲۸.۶ درصد کاهش داده است. شرکت Bell نیز از RAG برای مدیریت و بهروزرسانی سیاستهای داخلی خود استفاده میکند و به کارمندان اجازه میدهد تا به سرعت به اطلاعات دقیق و بهروز دسترسی پیدا کنند.

- کاربردهای دیگر: RAG در حوزههای دیگری مانند دستیار پزشک در حوزه سلامت، تحلیلگر هوشمند برای دادههای مالی، و سیستمهای هوش فروش برای جمعآوری اطلاعات از یادداشتهای CRM و مکالمات گذشته نیز کاربرد دارد.

نتیجهگیری و توصیههای راهبردی

سیستم Retrieval-Augmented Generation (RAG) یک راهکار تحولآفرین برای غلبه بر محدودیتهای ذاتی مدلهای زبانی بزرگ (LLM) در محیطهای سازمانی است. با فراهم آوردن دسترسی به دادههای بهروز، محرمانه و اختصاصی، RAG به طور چشمگیری دقت، قابلیت اطمینان و ارتباط پاسخها را افزایش میدهد و خطر توهمزایی را کاهش میدهد. این چارچوب، یک تغییر پارادایم از “آموزش دانش در مدل” به “بازیابی دانش از پایگاه داده” را معرفی میکند که هزینهها را کاهش داده و انعطافپذیری سیستم را به شدت افزایش میدهد.

موفقیت در پیادهسازی یک سیستم RAG در مقیاس سازمانی، به عوامل متعددی بستگی دارد که فراتر از یک کدنویسی ساده هستند. انتخاب صحیح ابزارها، از فریمورکهای توسعه مانند LangChain و LlamaIndex گرفته تا پایگاههای داده برداری مانند Chroma و Pinecone، حیاتی است. همچنین، بهرهگیری از تکنیکهای پیشرفته مانند Branched RAG و Agentic RAG برای حل پرسشهای پیچیده سازمانی ضروری است. در نهایت، ملاحظات غیرفنی مانند امنیت، حاکمیت داده، و مقیاسپذیری، بزرگترین چالشهای پیش رو هستند که نیازمند طراحی یک معماری ماژولار، پیادهسازی کنترل دسترسی مبتنی بر نقش و ایجاد سیستمهای ممیزی جامع هستند.

برای سازمانی که به دنبال شروع یک پروژه RAG است، نقشه راه زیر توصیه میشود:

- فاز اول: اثبات مفهوم (PoC): با یک سیستم RAG ساده بر روی یک مجموعه داده کوچک شروع کنید. از ابزارهای سبکوزن مانند LlamaIndex یا LangChain و یک پایگاه داده محلی مانند ChromaDB استفاده کنید. هدف در این فاز، اثبات قابلیت و پتانسیل RAG برای حل یک مشکل مشخص است.

- فاز دوم: پیادهسازی آزمایشی: با موفقیت PoC، پروژه را با دادههای بیشتر مقیاسدهی کنید. تکنیکهای پیشرفته مانند Reranking را آزمایش و عملکرد سیستم را به دقت ارزیابی کنید. در این مرحله، استفاده از پایگاههای داده برداری توزیعشده مانند Pinecone یا Qdrant را برای مقیاسپذیری بیشتر بررسی کنید.

- فاز سوم: تولید (Production): پیش از استقرار نهایی، به ملاحظات امنیتی، حاکمیت داده، و مانیتورینگ سیستم توجه کامل داشته باشید. تیمهای بینرشتهای از کارشناسان داده، امنیت، و حقوقی را درگیر کنید تا اطمینان حاصل شود که سیستم با استانداردهای سازمانی و مقررات مطابقت دارد. پیادهسازی سیستمهای Caching و معماری ماژولار را برای کاهش تأخیر و مدیریت بهینه منابع در اولویت قرار دهید.