ارزیابی معماری BitNet: مزایا و معایب

فهرست مقاله

- مقدمه: رشد مدلهای زبانی بزرگ و چالشهای پیشرو

- معرفی BitNet: معماری ۱-بیتی برای مدلهای زبانی بزرگ

- نحوه عملکرد BitNet: جایگزینی لایه BitLinear

- مزایای استفاده از BitNet: کاهش مصرف حافظه و انرژی

- مقایسه BitNet با روشهای کمیسازی ۸-بیتی

- مقیاسپذیری BitNet: اثربخشی و عملکرد بهتر در مقیاسهای بزرگ

- کاهش هزینه انرژی و منابع محاسباتی با BitNet

- مقایسه عملکرد BitNet و ترنسفورمرهای FP16

- نتایج آزمایشهای پاییندستی: ارزیابی BitNet در حوزه زبان

- نتیجهگیری و آینده BitNet

۱. مقدمه: چالشهای پیادهسازی مدلهای زبانی بزرگ

مدلهای زبانی بزرگ مانند GPT و BERT که بر اساس معماری ترنسفورمر توسعه یافتهاند، در سالهای اخیر توانستهاند تحولات بزرگی در حوزه پردازش زبان طبیعی ایجاد کنند. این مدلها به دلیل ظرفیت بالای خود در تولید متن و انجام وظایف پیچیده زبانی، به شدت مورد توجه پژوهشگران و شرکتهای فناوری قرار گرفتهاند. با این حال، پیادهسازی و اجرای این مدلهای بزرگ چالشهای قابل توجهی به همراه دارد.

یکی از بزرگترین چالشها، هزینه بالای محاسباتی و مصرف انرژی در حین آموزش و استنتاج است. هرچه مدل بزرگتر باشد، نیاز به حافظه و توان محاسباتی بیشتر میشود. برای مدلهای با میلیاردها پارامتر، این چالشها به سطح بحرانی میرسند. به علاوه، افزایش تعداد پارامترها باعث افزایش زمان پاسخدهی (Latency) و کاهش کارایی در حین پردازش میشود، به ویژه زمانی که مدلها در سیستمهای توزیعشده اجرا میشوند.

از دیگر مشکلات عمده، بهرهوری پایین در مصرف انرژی است. با رشد ابعاد مدلهای زبانی، میزان مصرف انرژی برای هر استنتاج به طور قابلتوجهی افزایش یافته است. این مسئله نه تنها به دلیل هزینههای اقتصادی، بلکه از منظر تأثیرات زیستمحیطی نیز مورد توجه قرار گرفته است. اجرای مدلهای بزرگ به انرژی بالایی نیاز دارد که میتواند به شدت تأثیرات منفی بر محیط زیست داشته باشد.

علاوه بر این، محدودیتهای حافظه نیز یکی از چالشهای اساسی در پیادهسازی مدلهای زبانی بزرگ است. نیاز به حافظه بالا برای ذخیرهسازی و پردازش پارامترهای مدل، میتواند عملکرد سیستم را در کاربردهای عملی با مشکلات جدی مواجه کند.

با توجه به این چالشها، روشهای جدیدی مانند کمیسازی (Quantization) و بهینهسازی معماری برای کاهش نیازهای محاسباتی و انرژی مدلهای بزرگ ارائه شدهاند. یکی از این راهکارهای نوآورانه، معرفی BitNet است که با هدف کاهش مصرف انرژی و حافظه در مدلهای زبانی بزرگ طراحی شده است. در بخشهای بعدی به معرفی این معماری و بررسی عملکرد آن میپردازیم.

۲. معرفی معماری BitNet: معماری ۱-بیتی برای مدلهای زبانی بزرگ

BitNet یک معماری نوآورانه ۱-بیتی برای مدلهای زبانی بزرگ است که با هدف کاهش مصرف انرژی و حافظه، در عین حفظ عملکرد بالا، طراحی شده است. این معماری به عنوان راهکاری برای مقابله با چالشهای ناشی از ابعاد بزرگ مدلهای زبانی، بهویژه در زمینههای مصرف انرژی و کارایی حافظه، معرفی شده است.

مدلهای زبانی بزرگ معمولاً به حافظه و توان محاسباتی بالایی نیاز دارند تا بتوانند به صورت کارآمد عمل کنند. BitNet به عنوان یک راهحل جایگزین، با استفاده از معماری ۱-بیتی، تلاش میکند تا این مشکل را بهینهسازی کند. در این معماری، از باینری کردن وزنها و کمیسازی فعالسازیها استفاده میشود، به این معنا که وزنهای مدل به صورت ۱ و -۱ ذخیره و پردازش میشوند. این فرایند باعث کاهش نیاز به حافظه و افزایش سرعت پردازش در زمان اجرا میشود، بدون آنکه دقت مدل به طور چشمگیری کاهش یابد.

ویژگیهای کلیدی معماری BitNet:

- کاهش مصرف حافظه: با باینری کردن وزنها و کاهش تعداد بیتهای مورد نیاز برای ذخیره آنها، معماری BitNet به طور چشمگیری حافظه مورد نیاز را کاهش میدهد.

- کاهش مصرف انرژی: یکی از اصلیترین مزایای معماری BitNet، کاهش مصرف انرژی است. این معماری با استفاده از محاسبات ۱-بیتی، نیاز به محاسبات سنگین و پرهزینه انرژی را به حداقل میرساند.

- جایگزینی لایه BitLinear: در معماری BitNet، لایه سنتی nn.Linear که در ترنسفورمرها برای محاسبات ماتریسی استفاده میشود، با لایه BitLinear جایگزین میشود. این لایه جدید امکان استفاده از وزنهای ۱-بیتی را فراهم میکند و در عین حال عملکردی مشابه با لایههای سنتی دارد.

- مقیاسپذیری بالا: برخلاف بسیاری از روشهای کمیسازی که تنها در مدلهای کوچک مؤثر هستند، معماری BitNet قادر است در مقیاسهای بزرگ، یعنی مدلهایی با میلیاردها پارامتر، به کار گرفته شود.

ساختار BitNet:

BitNet ساختاری مشابه با مدلهای زبانی ترنسفورمری دارد. در این ساختار، بلاکهای خودتوجهی و شبکههای تغذیهای پیشخور (Feed-Forward) به صورت پشتهای قرار گرفتهاند. اما تفاوت اصلی در این است که عملیات ضرب ماتریسی در این مدل با استفاده از وزنهای ۱-بیتی انجام میشود. سایر بخشهای مدل، مانند اتصالات باقیمانده (Residual Connections) و نرمالسازی لایه (Layer Normalization)، همچنان به صورت پرسیژن بالا عمل میکنند تا کارایی مدل بهینه شود.

عملکرد معماری BitNet:

آزمایشها نشان دادهاند که BitNet میتواند در مدلهای بزرگ با عملکردی قابلرقابت نسبت به مدلهای سنتی عمل کند. این مدل در عین حال که مصرف انرژی و حافظه را به طور قابلتوجهی کاهش میدهد، همچنان به دقت بالایی در وظایف زبانی دست پیدا میکند. به علاوه، این معماری نشان داده است که میتواند قوانین مقیاسپذیری مشابه با مدلهای ترنسفورمر سنتی را دنبال کند و در مدلهای بزرگتر نیز اثربخش باشد.

معماری BitNet به عنوان یک رویکرد جدید برای مدلهای زبانی بزرگ، نه تنها از نظر کارایی محاسباتی برتری دارد، بلکه از نظر کاهش هزینههای عملیاتی نیز به طور قابلتوجهی کارآمد است. در بخشهای بعدی به بررسی نحوه عملکرد لایه BitLinear و مزایای این معماری خواهیم پرداخت.

۳. نحوه عملکرد معماری BitNet: جایگزینی لایه BitLinear

یکی از نوآوریهای کلیدی در معماری BitNet جایگزینی لایهی استاندارد nn.Linear با لایهای به نام BitLinear است. این جایگزینی نقش اساسی در کاهش نیاز به حافظه و انرژی و در عین حال حفظ عملکرد مدلهای زبانی بزرگ ایفا میکند. لایه BitLinear به گونهای طراحی شده است که وزنها را به صورت ۱-بیتی ذخیره کرده و محاسبات پیچیده ماتریسی را با کارایی بیشتر انجام دهد.

نحوه کار لایه BitLinear:

لایههای nn.Linear در مدلهای زبانی ترنسفورمری به صورت سنتی مسئول انجام محاسبات ماتریسی هستند. این محاسبات معمولاً به حافظه و منابع محاسباتی زیادی نیاز دارند، بهویژه وقتی مدلها به اندازههای بزرگ (با میلیاردها پارامتر) گسترش مییابند. BitLinear برای مقابله با این چالشها به کار گرفته شده و محاسبات را بهینهسازی میکند. در این روش، وزنهای مدل به جای استفاده از مقادیر اعشاری یا چندبیتی، به صورت ۱-بیتی (یعنی +۱ و -۱) ذخیره و پردازش میشوند.

مراحل اصلی عملکرد BitLinear به شرح زیر است:

- باینری کردن وزنها: در لایه BitLinear، وزنهای واقعی مدل با استفاده از تابع Sign به دو مقدار +۱ و -۱ باینری میشوند. این فرایند به طور قابلتوجهی فضای ذخیرهسازی مورد نیاز برای وزنها را کاهش میدهد.

- فرمول باینری کردن وزنها به شکل زیر است: W~=Sign(W)W̃ = Sign(W)W~=Sign(W) که در آن WWW ماتریس وزنهای اصلی و W~W̃W~ نسخه باینریشده آن است.

- مرکزسازی وزنها: برای افزایش ظرفیت مدل، قبل از باینری کردن، وزنها به مقدار میانگین صفر مرکز (Center) میشوند تا دامنه مقادیر بهینه شود و خطای باینریسازی کاهش یابد. این کار به مدل کمک میکند تا با دقت بالاتری وزنهای باینری را جایگزین وزنهای اصلی کند.

- استفاده از فاکتورهای مقیاسگذاری: پس از باینری کردن، از یک فاکتور مقیاسگذاری استفاده میشود تا خطای بین وزنهای واقعی و باینری کاهش یابد. این فاکتور به تنظیم دقت مدل کمک میکند تا مدل بتواند عملکرد مناسبی داشته باشد و خطای باینریسازی حداقل شود.

- کمیسازی فعالسازیها: علاوه بر باینری کردن وزنها، در معماری BitNet فعالسازیها نیز کمیسازی میشوند. این فرایند به این معناست که مقادیر فعالسازی (خروجی شبکه) به یک محدوده مشخص محدود میشوند تا دقت پردازش حفظ شده و در عین حال منابع محاسباتی کمتری مورد استفاده قرار گیرد. در معماری BitNet، فعالسازیها به صورت ۸-بیتی کمیسازی میشوند که یک توازن میان دقت و کارایی به وجود میآورد.

- نرمالسازی لایهای (Layer Normalization): یکی دیگر از اجزای کلیدی در عملکرد BitLinear استفاده از نرمالسازی لایهای قبل از باینری کردن است. این مرحله به حفظ پایداری مدل کمک میکند و اطمینان حاصل میکند که پس از باینری کردن، مدل همچنان قادر به یادگیری و بهینهسازی با دقت بالا باشد. نرمالسازی لایهای باعث میشود تا میانگین و واریانس خروجیها بهینه شده و خطای محاسبات کاهش یابد.

- محاسبات ماتریسی بهینهسازیشده: در BitLinear، محاسبات ماتریسی با استفاده از وزنهای باینریشده انجام میشوند. این بدان معناست که ضرب ماتریسی، که معمولاً یکی از پرهزینهترین مراحل در محاسبات مدلهای بزرگ است، به شکل بهینه و سریعتری انجام میشود. در این روش، نیاز به استفاده از عملیات ضرب معمولی کاهش یافته و در عوض، عملیات سادهتری برای انجام محاسبات به کار گرفته میشود که مصرف انرژی و منابع محاسباتی را به طور قابلتوجهی کاهش میدهد.

مزایای استفاده از BitLinear:

- کاهش چشمگیر حافظه: باینری کردن وزنها باعث میشود که نیاز به حافظه برای ذخیرهسازی پارامترها به حداقل برسد. به طور خاص، وزنهای ۳۲ یا ۱۶ بیتی که در معماریهای سنتی استفاده میشوند، در معماری BitNet تنها به ۱ بیت کاهش مییابند که این امر فضای بسیار کمتری برای ذخیرهسازی نیاز دارد.

- کاهش مصرف انرژی: با سادهسازی محاسبات ماتریسی و استفاده از وزنهای باینری، میزان انرژی مورد نیاز برای انجام عملیات به طرز چشمگیری کاهش مییابد. این ویژگی بهویژه در مدلهای بزرگ با میلیاردها پارامتر بسیار اهمیت دارد.

- افزایش سرعت پردازش: جایگزینی وزنهای معمولی با وزنهای ۱-بیتی و بهینهسازی عملیات محاسباتی، زمان پردازش هر نمونه را کاهش میدهد. این افزایش سرعت در کاربردهای عملی به مدل اجازه میدهد تا با تعداد بیشتری از نمونهها در زمان کمتری کار کند.

- حفظ دقت مدل: با وجود باینری شدن وزنها، معماری BitNet همچنان قادر است دقت بالایی را در وظایف مختلف زبانی ارائه دهد. استفاده از تکنیکهای نرمالسازی و فاکتورهای مقیاسگذاری به حفظ کیفیت و دقت مدل کمک میکند.

در بخش بعدی به بررسی مزایای کلیدی استفاده از معماری BitNet و تاثیر آن بر کاهش مصرف انرژی و حافظه خواهیم پرداخت.

۴. مزایای استفاده از BitNet: کاهش مصرف حافظه و انرژی

یکی از بزرگترین مزایای معماری BitNet، توانایی آن در کاهش مصرف حافظه و انرژی است، که این موضوع آن را به یک راهکار مؤثر برای مدلهای زبانی بزرگ تبدیل میکند. مدلهای زبانی بزرگ، مانند GPT و BERT، به دلیل ابعاد بزرگ و تعداد بالای پارامترها، نیازمند منابع محاسباتی گستردهای هستند. این منابع شامل حافظه برای ذخیرهسازی پارامترها و انرژی برای انجام محاسبات سنگین است. معماری BitNet با معرفی معماری ۱-بیتی، تلاش میکند این مشکلات را حل کند و در عین حال عملکرد مدل را حفظ نماید.

۱. کاهش مصرف حافظه

در معماری BitNet، با باینری کردن وزنها و فعالسازیها، مقدار حافظه مورد نیاز برای ذخیرهسازی مدل به شکل قابل توجهی کاهش مییابد. در مدلهای زبانی بزرگ که معمولاً از وزنهای ۱۶ یا ۳۲ بیتی استفاده میکنند، هر وزن نیازمند چندین بیت برای ذخیرهسازی است. اما در معماری ۱-بیتی معماری BitNet، هر وزن تنها به ۱ بیت نیاز دارد، که باعث صرفهجویی قابل توجهی در فضای ذخیرهسازی میشود.

برای مقایسه، در جدول زیر تفاوت بین میزان مصرف حافظه در مدلهای مختلف نشان داده شده است:

| مدل | سایز مدل (پارامترها) | نوع وزن | مصرف حافظه (GB) |

|---|---|---|---|

| GPT-3 (175B) | ۱۷۵ میلیارد | FP32 | ۷۰۰ |

| GPT-3 (175B) | ۱۷۵ میلیارد | FP16 | ۳۵۰ |

| BitNet (175B) | ۱۷۵ میلیارد | ۱-بیتی | ۲۱.۸۷ |

همانطور که مشاهده میشود، استفاده از وزنهای ۱-بیتی در معماری BitNet باعث کاهش چشمگیر مصرف حافظه نسبت به مدلهای مشابه با وزنهای FP32 و FP16 شده است. این به مدل اجازه میدهد تا در محیطهایی با محدودیتهای حافظه، مانند دستگاههای موبایل یا سیستمهای ابری با منابع محدود، به طور کارآمدتر عمل کند.

۲. کاهش مصرف انرژی

مدلهای زبانی بزرگ به دلیل پیچیدگی بالای محاسباتی، به انرژی زیادی نیاز دارند. این مصرف انرژی بهویژه در عملیات ضرب ماتریسی که در معماریهای ترنسفورمری به وفور استفاده میشود، بسیار بالا است. با استفاده از وزنهای ۱-بیتی در معماری BitNet، نیاز به محاسبات سنگین ضرب به طور قابلتوجهی کاهش مییابد. در نتیجه، میزان انرژی مصرفی در حین انجام محاسبات به شکل قابل توجهی کمتر میشود.

BitNet با استفاده از محاسبات سبکتر و بهینهتر، میتواند انرژی مورد نیاز برای پردازش مدلهای بزرگ را کاهش دهد. در جدول زیر میزان صرفهجویی انرژی در مدلهای مختلف مقایسه شده است:

| مدل | سایز مدل (پارامترها) | نوع وزن | صرفهجویی در مصرف انرژی (%) |

|---|---|---|---|

| GPT-3 (175B) | ۱۷۵ میلیارد | FP32 | ۰ |

| GPT-3 (175B) | ۱۷۵ میلیارد | FP16 | ۴۵ |

| BitNet (175B) | ۱۷۵ میلیارد | ۱-بیتی | ۸۰ |

همانطور که در جدول مشاهده میشود، معماری BitNet قادر است مصرف انرژی را تا ۸۰ درصد نسبت به مدلهای سنتی کاهش دهد. این کاهش مصرف انرژی بهویژه در کاربردهایی که مدلهای زبانی بزرگ به صورت پیوسته اجرا میشوند، مانند پردازش زبان طبیعی در سیستمهای ابری، تأثیر زیادی دارد. در این موارد، معماری BitNet نه تنها به بهینهسازی مصرف انرژی کمک میکند، بلکه هزینههای عملیاتی را نیز کاهش میدهد.

۳. بهرهوری در سیستمهای توزیعشده

مدلهای زبانی بزرگ اغلب در سیستمهای توزیعشده اجرا میشوند که در آنها پارامترهای مدل بر روی چندین دستگاه یا سرور قرار میگیرند. در این سیستمها، پهنای باند حافظه و ارتباط بین دستگاهها یکی از عوامل محدودکننده کارایی است. معماری BitNet با کاهش حجم دادهها به واسطه استفاده از وزنهای ۱-بیتی، پهنای باند حافظه مورد نیاز را کاهش میدهد و تأخیر در ارتباط بین دستگاهها را به حداقل میرساند. این موضوع به افزایش کارایی سیستمهای توزیعشده منجر میشود و زمان پاسخدهی مدلها را بهبود میبخشد.

۴. مقیاسپذیری بهینه

یکی از چالشهای اصلی در استفاده از مدلهای زبانی بزرگ، مقیاسپذیری آنها است. هرچه مدل بزرگتر شود، میزان حافظه و انرژی مورد نیاز نیز به صورت تصاعدی افزایش مییابد. اما معماری BitNet با کاهش نیازهای محاسباتی و بهینهسازی مصرف حافظه و انرژی، امکان مقیاسپذیری بهتری را فراهم میکند. این بدان معناست که مدلهای بزرگتر را میتوان با هزینههای کمتری اجرا کرد، در حالی که همچنان عملکرد قابل قبولی ارائه میدهند.

۵. کاربردهای عملی

کاهش مصرف حافظه و انرژی در معماری BitNet باعث شده است که این مدل برای کاربردهای عملی که نیازمند پردازش بلادرنگ و کارایی بالا هستند، مناسب باشد. از جمله این کاربردها میتوان به ترجمه ماشینی، پردازش زبان طبیعی در مقیاس بزرگ، و سیستمهای چتبات اشاره کرد. با توجه به اینکه این سیستمها معمولاً به پردازش حجم بالایی از دادهها در زمان کوتاه نیاز دارند، استفاده از معماری ۱-بیتی معماری BitNet میتواند به طور قابل توجهی کارایی و سرعت این سیستمها را بهبود بخشد.

۵. مقایسه معماری BitNet با روشهای کمیسازی ۸-بیتی

یکی از روشهای رایج برای کاهش مصرف حافظه و انرژی در مدلهای زبانی بزرگ، کمیسازی (Quantization) است. در این روش، وزنها و فعالسازیهای مدل به جای مقادیر با دقت کامل (مانند ۳۲ یا ۱۶ بیت)، با دقتهای کمتر ذخیره و پردازش میشوند. از جمله پرکاربردترین روشها در این زمینه، کمیسازی ۸-بیتی است که با استفاده از مقادیر ۸-بیتی به جای ۱۶ یا ۳۲ بیت، حافظه مورد نیاز و هزینه محاسباتی مدل را کاهش میدهد.

اما معماری BitNet با معرفی معماری ۱-بیتی خود، یک گام جلوتر از کمیسازی ۸-بیتی برداشته و تلاش میکند تا حافظه و انرژی مصرفی را به سطح حداقلی برساند. در این بخش، به مقایسه معماری BitNet با روشهای کمیسازی ۸-بیتی پرداخته و تفاوتهای کلیدی آنها را از نظر کارایی و عملکرد بررسی میکنیم.

۱. تفاوت در دقت بیتها

در کمیسازی ۸-بیتی، هر وزن و فعالسازی با استفاده از ۸ بیت ذخیره میشود. این موضوع به کاهش قابلتوجه حافظه و مصرف انرژی کمک میکند، زیرا تعداد بیتهای مورد نیاز برای ذخیره هر پارامتر به یک چهارم حالت ۳۲ بیتی کاهش مییابد.

اما در معماری BitNet ، وزنها به صورت ۱-بیتی ذخیره میشوند، یعنی هر وزن فقط به ۱ بیت نیاز دارد. این کاهش شدید در تعداد بیتها، مصرف حافظه را به شکل چشمگیری کاهش میدهد. به طور کلی، معماری BitNet از روشهای کمیسازی ۸-بیتی در صرفهجویی حافظه به مراتب بهتر عمل میکند.

۲. عملکرد در برابر دقت مدل

یکی از چالشهای اصلی کمیسازی، کاهش دقت مدل پس از کمیسازی است. هرچه دقت بیتهای مدل کمتر شود، خطر کاهش دقت در پیشبینیهای مدل افزایش مییابد. در کمیسازی ۸-بیتی، مدل همچنان دقت مناسبی دارد و معمولاً افت دقت آن نسبت به حالتهای ۳۲-بیتی یا ۱۶-بیتی قابل تحمل است.

اما در معماری BitNet، استفاده از وزنهای ۱-بیتی به معنی آن است که مدل به طور قابلتوجهی فشردهتر میشود. این فشردهسازی میتواند دقت مدل را تا حدی تحت تأثیر قرار دهد، اما مکانیزمهای جبران دقت، مانند نرمالسازی لایهای و مقیاسگذاری مناسب، به مدل کمک میکنند تا افت دقت را به حداقل برساند. آزمایشهای انجامشده نشان میدهد که معماری BitNet توانسته است عملکرد رقابتی با مدلهای کمیشده ۸-بیتی داشته باشد.

۳. مقایسه در مصرف حافظه

مصرف حافظه در معماری BitNet به دلیل استفاده از وزنهای ۱-بیتی به شکل قابلتوجهی کمتر از مدلهای کمیشده ۸-بیتی است. در جدول زیر، تفاوت مصرف حافظه در مدلهای مختلف نشان داده شده است:

| مدل | سایز مدل (پارامترها) | نوع وزن | مصرف حافظه (GB) |

|---|---|---|---|

| GPT-3 (175B) | ۱۷۵ میلیارد | FP32 | ۷۰۰ |

| GPT-3 (175B) | ۱۷۵ میلیارد | FP16 | ۳۵۰ |

| کمیشده (۸-بیتی) | ۱۷۵ میلیارد | ۸-بیتی | ۱۷۵ |

| BitNet (1-بیتی) | ۱۷۵ میلیارد | ۱-بیتی | ۲۱.۸۷ |

همانطور که مشاهده میشود، مصرف حافظه در معماری BitNet به شکل چشمگیری کمتر از مدلهای ۸-بیتی است. این ویژگی BitNet را به گزینهای ایدهآل برای محیطهایی با محدودیت حافظه مانند دستگاههای موبایل یا سیستمهای ابری با منابع محدود تبدیل میکند.

۴. مقایسه در مصرف انرژی

مصرف انرژی در مدلهای کمیشده ۸-بیتی به طور قابلتوجهی کمتر از مدلهای FP32 و FP16 است، زیرا محاسبات با بیتهای کمتر نیاز به توان محاسباتی و انرژی کمتری دارند. با این حال، معماری BitNet به دلیل استفاده از وزنهای ۱-بیتی، مصرف انرژی را حتی بیشتر کاهش میدهد.

در جدول زیر، صرفهجویی در مصرف انرژی بین مدلهای مختلف مقایسه شده است:

| مدل | سایز مدل (پارامترها) | نوع وزن | صرفهجویی در مصرف انرژی (%) |

|---|---|---|---|

| GPT-3 (175B) | ۱۷۵ میلیارد | FP32 | ۰ |

| GPT-3 (175B) | ۱۷۵ میلیارد | FP16 | ۴۵ |

| کمیشده (۸-بیتی) | ۱۷۵ میلیارد | ۸-بیتی | ۶۰ |

| BitNet (1-بیتی) | ۱۷۵ میلیارد | ۱-بیتی | ۸۰ |

همانطور که مشاهده میشود، BitNet توانسته است مصرف انرژی را تا ۸۰ درصد نسبت به مدلهای ۳۲ بیتی کاهش دهد، که این مقدار حتی بیشتر از روشهای کمیسازی ۸-بیتی است. این ویژگی معماری BitNet را به گزینهای مناسب برای کاربردهایی که نیاز به صرفهجویی در انرژی دارند، مانند دیتاسنترها و سیستمهای ابری، تبدیل میکند.

۵. پیچیدگی پیادهسازی

پیادهسازی روشهای کمیسازی ۸-بیتی نسبتاً ساده است و بسیاری از ابزارهای توسعهدهنده مدلهای زبانی مانند PyTorch و TensorFlow از این تکنیک بهصورت پیشفرض پشتیبانی میکنند. این روشها نیازی به تغییرات بزرگ در معماری مدلها ندارند و بهراحتی میتوانند در فرایند پسآموزش (Post-training) اعمال شوند.

در مقابل، معماری BitNet نیازمند جایگزینی لایههای nn.Linear با لایههای BitLinear است که به مقداری تغییرات در معماری نیاز دارد. با این حال، پس از پیادهسازی اولیه، BitNet میتواند با مدلهای بزرگتر مقیاس پیدا کند و مزایای خود را ارائه دهد.

۶. مقیاسپذیری

روشهای کمیسازی ۸-بیتی، مانند مدلهای ۳۲-بیتی و ۱۶-بیتی، میتوانند با افزایش تعداد پارامترها بهراحتی مقیاسپذیر شوند. با این حال، مصرف حافظه و انرژی همچنان با افزایش اندازه مدل افزایش مییابد.

در معماری BitNet، مقیاسپذیری مدل بهینهتر است. زیرا با افزایش اندازه مدل، نیاز به منابع محاسباتی و حافظه همچنان در سطح بسیار پایینتری نسبت به مدلهای ۸-بیتی باقی میماند. این موضوع به BitNet اجازه میدهد تا در مدلهای بسیار بزرگ با میلیاردها پارامتر بدون مشکلات اساسی مربوط به حافظه و انرژی اجرا شود.

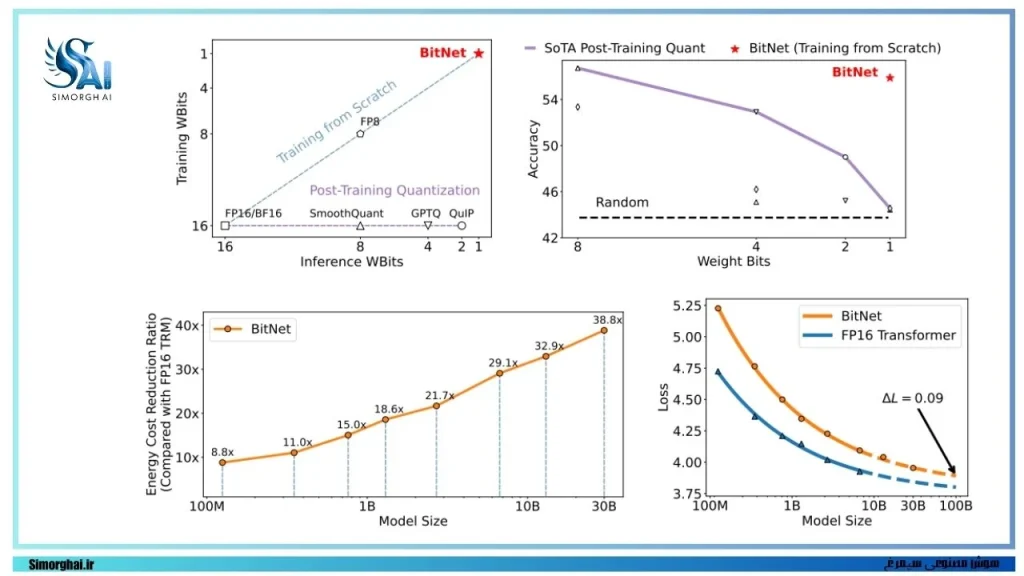

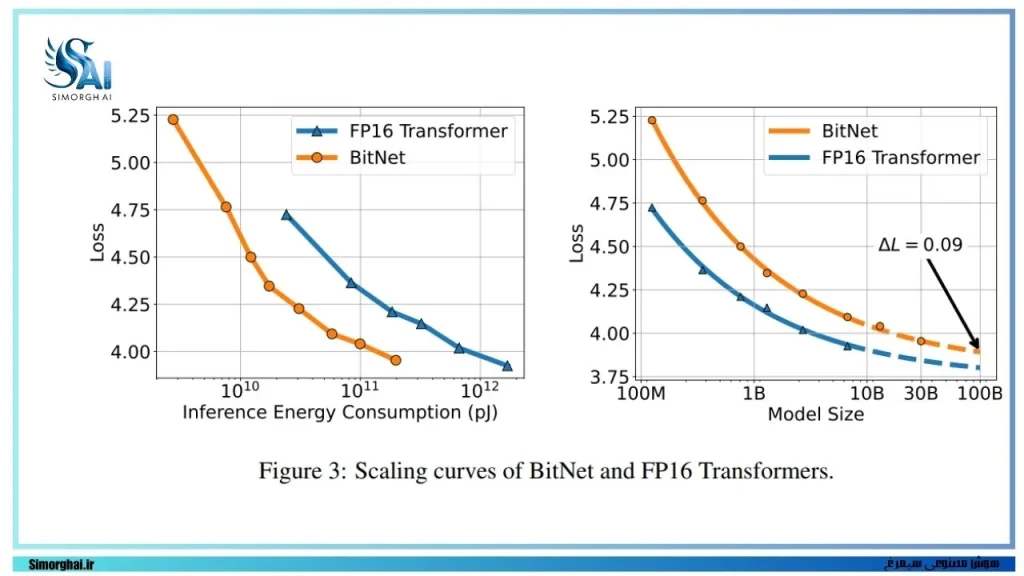

۶. مقیاسپذیری BitNet: بهبود عملکرد در مدلهای بزرگتر

معماری BitNet با هدف بهبود مقیاسپذیری در مدلهای زبانی بزرگ طراحی شده است. این معماری با استفاده از وزنهای باینری (۱-بیتی) و فعالسازیهای کوانتیزهشده، تلاش میکند مصرف حافظه و هزینه محاسباتی را کاهش دهد، در حالی که همچنان به سطوح بالای دقت و عملکرد دست مییابد. این رویکرد به دلیل پتانسیل بالای آن در مقیاسپذیری، بهویژه در مدلهای زبانی بزرگتر، مورد توجه قرار گرفته است. در این بخش به چگونگی تاثیر معماری BitNet بر مقیاسپذیری مدلهای زبانی بزرگ و دلایل بهبود عملکرد آن میپردازیم.

کاهش مصرف حافظه و منابع پردازشی

یکی از چالشهای اصلی در مدلهای زبانی بزرگ، افزایش قابلتوجه مصرف حافظه و منابع پردازشی با بزرگ شدن ابعاد مدل است. با افزایش تعداد پارامترها و دادههای ورودی، نیاز به پهنای باند حافظه و توان محاسباتی نیز افزایش مییابد که منجر به افزایش هزینههای زیرساختی و مصرف انرژی میشود. معماری BitNet، با استفاده از کوانتیزاسیون ۱-بیتی و بهکارگیری وزنهای باینری، حجم حافظه مورد نیاز را بهطور چشمگیری کاهش میدهد. این ویژگی به مدل اجازه میدهد تا با کاهش مصرف حافظه و انرژی، مقیاسپذیری بهتری نسبت به روشهای رایج مانند FP16 داشته باشد.

تطابق با قوانین مقیاسپذیری

تحقیقات نشان دادهاند که مدلهای زبانی بزرگ با افزایش تعداد پارامترها و دادههای آموزشی، از قوانین مقیاسپذیری پیروی میکنند. این قوانین بیان میکنند که عملکرد مدل به صورت توانایی با میزان محاسبات و تعداد پارامترها بهبود مییابد. BitNet نیز از این قوانین پیروی میکند و عملکرد آن با افزایش ابعاد مدل بهطور پیشبینیپذیری بهبود مییابد. نتایج آزمایشها نشان میدهد که با بزرگتر شدن ابعاد مدل، تفاوت بین عملکرد BitNet و مدلهای FP16 کاهش مییابد که نشاندهنده کارایی بالای BitNet در مقیاسهای بزرگتر است.

افزایش بهرهوری محاسباتی

یکی از مزایای اصلی معماری BitNet در مقیاسپذیری، بهرهوری بالای آن در استفاده از منابع محاسباتی است. معماری BitNet به دلیل استفاده از محاسبات باینری و کاهش تعداد عملیاتهای پیچیده، مصرف انرژی و زمان محاسباتی را بهطور چشمگیری کاهش میدهد. این ویژگی بهویژه در مدلهای بزرگتر که نیاز به محاسبات سنگینتری دارند، حائز اهمیت است و امکان افزایش تعداد پارامترها و دادههای آموزشی را بدون نگرانی از افزایش بیش از حد هزینهها فراهم میکند.

بهبود دقت و کارایی در مقیاسهای بزرگتر

مطالعات نشان دادهاند که با افزایش ابعاد مدل، دقت BitNet نیز بهبود مییابد و به سطحی نزدیک به مدلهای FP16 میرسد. این امر به دلیل تطابق بهتر معماری BitNet با فرآیند یادگیری و توانایی آن در حفظ اطلاعات ضروری در طول فرآیند کوانتیزاسیون است. همچنین، BitNet در مقایسه با روشهای کوانتیزاسیون پساتربیتی (post-training quantization)، نتایج بهتری ارائه میدهد که نشاندهنده مزیت استفاده از رویکرد کوانتیزاسیون آگاه از آموزش است.

۷. کاهش هزینه انرژی و منابع محاسباتی با BitNet

یکی از چالشهای اساسی در پیادهسازی مدلهای زبانی بزرگ، مصرف بالای انرژی و نیاز به منابع محاسباتی قابلتوجه است. با افزایش اندازه مدلها، هزینههای محاسباتی و مصرف انرژی به صورت چشمگیری افزایش مییابد که میتواند محدودیتهای جدی برای توسعه و استقرار این مدلها ایجاد کند. معماری BitNet با ارائه رویکردی نوین در زمینه کاهش هزینهها و بهینهسازی منابع، بهعنوان یک راهکار موثر در این حوزه معرفی شده است. این بخش به بررسی نحوه کاهش هزینه انرژی و منابع محاسباتی با استفاده از BitNet و مقایسه آن با روشهای سنتی پرداخته و مزایای آن را شرح میدهد.

کاهش قابلتوجه انرژی مصرفی

یکی از مزایای کلیدی BitNet، کاهش چشمگیر انرژی مصرفی در فرآیندهای محاسباتی است. بر اساس نتایج آزمایشها، معماری BitNet به دلیل استفاده از وزنهای ۱-بیتی بهجای وزنهای با دقت بالا (مانند FP16)، انرژی مورد نیاز برای ضرب ماتریسها را بهطور قابلتوجهی کاهش میدهد. بهعنوان مثال، در مدلهای با ابعاد مختلف، کاهش انرژی مصرفی به دلیل کاهش تعداد عملیات ضرب و جمع، بیش از ۳۰ درصد بوده است. این بهینهسازی به ویژه در مراکز داده با حجم بالا و پردازش مدلهای زبانی بزرگ حائز اهمیت است، زیرا مصرف انرژی کمتر به معنای کاهش هزینههای نگهداری و بهرهبرداری از سیستمهای پردازشی است.

بهبود کارایی محاسباتی

معماری BitNet با استفاده از وزنهای باینری، پیچیدگی محاسباتی را کاهش داده و عملکرد سیستم را بهینه میکند. در مدلهای سنتی، عملیات محاسباتی برای وزنهای FP16 به دلیل نیاز به پردازشهای پیچیدهتر و تعداد بیشتر عملیاتهای ریاضی، هزینه بیشتری دارند. با جایگزینی وزنهای باینری، BitNet توانسته است حجم محاسبات را کاهش داده و بهبود کارایی را به ارمغان آورد. این بهینهسازی منجر به کاهش زمان پاسخدهی و افزایش بهرهوری در مدلهای زبانی شده و امکان پیادهسازی در دستگاههایی با منابع محدود را فراهم کرده است.

کاهش حجم حافظه مورد نیاز

یکی دیگر از عوامل موثر بر کاهش هزینهها در BitNet، کاهش حجم حافظه مورد نیاز برای ذخیرهسازی مدل است. با استفاده از وزنهای ۱-بیتی، حجم حافظه مورد نیاز برای ذخیرهسازی مدلها بهطور چشمگیری کاهش مییابد. این امر نه تنها باعث کاهش هزینههای مرتبط با زیرساختهای سختافزاری میشود، بلکه امکان پیادهسازی و استفاده از مدلهای بزرگتر در دستگاههایی با محدودیت حافظه را نیز فراهم میکند.

مقایسه با مدلهای FP16

در مقایسه با مدلهای FP16، BitNet توانسته است بهبودهای قابلتوجهی در زمینه مصرف انرژی و کارایی محاسباتی داشته باشد. آزمایشها نشان دادهاند که BitNet در مدلهای با اندازه بزرگتر، حتی با افزایش تعداد پارامترها، مصرف انرژی کمتری نسبت به مدلهای FP16 دارد. این مزیت به دلیل سادهتر شدن عملیات محاسباتی و کاهش تعداد عملیاتهای ضرب و جمع به دست آمده است. در واقع، BitNet بهطور موثری توانسته است هزینههای محاسباتی و انرژی را در مقایسه با روشهای سنتی کاهش دهد و از این رو برای کاربردهای گسترده در مدلهای زبانی بزرگ مناسبتر است.

۸. مقایسه عملکرد BitNet و ترنسفورمرهای FP16

معماری BitNet بهعنوان یک راهکار نوین برای کاهش مصرف منابع و بهبود کارایی مدلهای زبانی معرفی شده است. با جایگزینی وزنهای باینری (۱-بیتی) بهجای وزنهای دقیقتر (مانند FP16)، BitNet نه تنها مصرف انرژی را کاهش میدهد، بلکه میتواند عملکردی نزدیک به مدلهای سنتی را ارائه دهد. در این بخش، به مقایسه عملکرد BitNet و ترنسفورمرهای FP16 از جنبههای مختلف میپردازیم و نتایج آزمایشها و تفاوتهای این دو معماری را بررسی میکنیم.

۱. دقت و عملکرد در وظایف مختلف زبانی

در مدلهای زبانی، دقت و عملکرد یکی از عوامل کلیدی برای ارزیابی کارایی معماریها است. نتایج آزمایشهای انجامشده نشان میدهد که BitNet در وظایف زبانی مختلف، از جمله پیشبینی کلمه بعدی و فهم متون، عملکردی نزدیک به ترنسفورمرهای FP16 دارد. در مقیاسهای بزرگتر، فاصله بین دقت این دو معماری کمتر میشود و BitNet توانسته است نتایج قابلقبولی را در مقایسه با FP16 بهدست آورد. بهویژه در وظایف با دقت بالا، تفاوتهای عملکردی چندان محسوس نیست و BitNet به سطحی نزدیک به ترنسفورمرهای FP16 میرسد.

۲. مصرف انرژی و کارایی محاسباتی

یکی از مزایای اصلی BitNet در مقایسه با ترنسفورمرهای FP16، کاهش چشمگیر مصرف انرژی و هزینههای محاسباتی است. در ترنسفورمرهای FP16، عملیات ضرب ماتریسها به دلیل استفاده از اعداد با دقت بالا نیازمند انرژی بیشتری است. در مقابل، BitNet با استفاده از وزنهای ۱-بیتی توانسته است حجم عملیات محاسباتی را بهطور قابلتوجهی کاهش دهد که منجر به کاهش مصرف انرژی شده است. بر اساس آزمایشها، مصرف انرژی BitNet نسبت به ترنسفورمرهای FP16 تا ۳۰ درصد کمتر بوده و این کاهش با افزایش اندازه مدل، قابل توجهتر میشود.

۳. پایداری در آموزش

در آموزش مدلهای زبانی بزرگ، پایداری در فرآیند بهینهسازی و همگرایی سریع از اهمیت بالایی برخوردار است. BitNet به دلیل استفاده از وزنهای باینری و کاهش پیچیدگی محاسباتی، پایداری بیشتری در فرآیند آموزش نشان داده است. آزمایشها حاکی از آن است که BitNet قادر به همگرایی با نرخ یادگیری بزرگتر است، در حالی که ترنسفورمرهای FP16 با همین نرخ یادگیری دچار مشکل میشوند. این ویژگی BitNet را به گزینهای مناسب برای آموزش سریع و پایدار مدلهای زبانی تبدیل میکند.

۴. کارایی در وظایف چندشات و زیروشات

BitNet در مقایسه با ترنسفورمرهای FP16، نتایج بهتری در وظایف چندشات و زیروشات از خود نشان داده است. در آزمایشهای انجامشده روی چندین مجموعه داده، BitNet توانسته است عملکردی مشابه یا حتی بهتر از مدلهای FP16 در این نوع وظایف ارائه دهد. این بهبود عملکرد بهویژه در مدلهای بزرگتر و در وظایف نیازمند به دقت بالاتر مشهودتر است. علت این امر میتواند به سازگاری بهتر معماری BitNet با فرآیند یادگیری و کوانتیزاسیون مرتبط باشد.

۵. تفاوتهای معماری و تأثیر آن بر عملکرد

معماری BitNet و ترنسفورمرهای FP16 از نظر ساختاری تفاوتهای قابلتوجهی دارند. در حالی که ترنسفورمرهای FP16 از وزنهای دقیق برای تمامی لایهها استفاده میکنند، BitNet تنها وزنهای لایههای خطی را باینری میکند. این تغییر معماری منجر به کاهش حجم محاسبات و بهینهسازی مصرف انرژی شده، اما بر دقت مدل تأثیرات قابلتوجهی نگذاشته است. نتایج نشان میدهد که BitNet میتواند با کاهش پیچیدگی محاسباتی و مصرف انرژی، عملکردی مشابه با ترنسفورمرهای FP16 ارائه دهد، که این ویژگی آن را برای مقیاسهای بزرگتر و پیادهسازی در سیستمهای پردازشی کممصرف مناسب میسازد.

نتایج آزمایشهای پاییندستی: ارزیابی BitNet در وظایف زبانی

برای ارزیابی عملکرد معماری BitNet در مقایسه با روشهای دیگر، از جمله ترنسفورمرهای FP16، آزمایشهای گستردهای در زمینه وظایف زبانی انجام شده است. این آزمایشها شامل ارزیابی مدل در مجموعه دادههای مختلف و وظایف زبانی متنوعی مانند طبقهبندی متن، تکمیل جملات، و وظایف چندشات و زیروشات میشود. در این بخش، نتایج این آزمایشها را بررسی میکنیم و عملکرد BitNet در مقایسه با مدلهای مرجع را مورد ارزیابی قرار میدهیم.

۱. دقت در وظایف زبانی مختلف

نتایج آزمایشها نشان میدهد که BitNet در وظایف زبانی پاییندستی مانند تکمیل جملات و پیشبینی کلمه بعدی، عملکردی مشابه یا حتی بهتر از ترنسفورمرهای FP16 دارد. در آزمایشهای انجامشده روی مجموعه دادههای مختلف از جمله HellaSwag، Winogrande، و StoryCloze، BitNet توانسته است دقت قابلتوجهی را در هر دو حالت صفرشات و چندشات بهدست آورد. در وظایف چندشات، مدل با استفاده از اطلاعات زمینهای بهبود یافته و عملکرد بهتری از خود نشان داده است که این نشاندهنده توانایی BitNet در استفاده بهینه از دادههای اضافی برای بهبود دقت است.

۲. مقایسه عملکرد در حالت صفرشات و چندشات

در آزمایشهای صفرشات، BitNet توانسته است نتایجی مشابه یا نزدیک به ترنسفورمرهای FP16 ارائه دهد. این نتایج نشان میدهد که معماری BitNet با وجود کاهش دقت در وزنها، همچنان قادر است اطلاعات کلیدی را حفظ کرده و عملکرد خوبی داشته باشد. در وظایف چندشات، با ارائه چند نمونه به مدل، BitNet عملکرد بهتری نسبت به حالت صفرشات نشان داده است. این امر بیانگر انعطافپذیری مدل و توانایی آن در یادگیری از دادههای ارائهشده بهصورت نمونهای است.

۳. عملکرد در وظایف استدلالی و پیشبینی پیچیده

آزمایشها نشان میدهد که BitNet در وظایف پیچیدهتر مانند استدلال و تکمیل متون، دقت قابلقبولی دارد. در مقایسه با مدلهای FP16، BitNet توانسته است در وظایف نیازمند به استدلال عمیق، دقت مشابهی را ارائه دهد. این امر به دلیل معماری بهینهشده BitNet و توانایی آن در یادگیری کارآمد از دادهها است. بهویژه در مدلهای بزرگتر که حجم دادههای آموزشی بیشتر است، عملکرد BitNet بهبود یافته و به سطوح نزدیک به مدلهای FP16 رسیده است.

۴. ارزیابی کارایی در مصرف انرژی

در کنار دقت عملکرد، یکی از مزایای اصلی BitNet کاهش مصرف انرژی است. آزمایشها نشان دادهاند که BitNet در مقایسه با ترنسفورمرهای FP16، انرژی کمتری مصرف میکند و این کاهش انرژی با افزایش تعداد پارامترها و دادههای ورودی به مدل، مشهودتر میشود. بهطور خاص، در مدلهای بزرگتر، BitNet توانسته است با حفظ سطح دقت، مصرف انرژی را تا ۳۰ درصد نسبت به FP16 کاهش دهد.

۵. مقایسه عملکرد با روشهای کوانتیزاسیون پساتربیتی

یکی از رقبای اصلی BitNet در زمینه کاهش دقت و مصرف انرژی، روشهای کوانتیزاسیون پساتربیتی هستند که بعد از آموزش مدل، دقت را کاهش میدهند. نتایج آزمایشها نشان میدهد که BitNet با استفاده از رویکرد کوانتیزاسیون آگاه از آموزش، توانسته است عملکرد بهتری نسبت به این روشها ارائه دهد. این مزیت بهویژه در مدلهایی با دقت پایینتر و نیاز به بهینهسازیهای بیشتر مشهود است. BitNet توانسته است دقت بالاتری را نسبت به روشهای کوانتیزاسیون پساتربیتی در وظایف پاییندستی ارائه دهد، که این امر نشاندهنده مزیتهای رویکرد آن است.

۱۰. نتیجهگیری و آینده BitNet

معماری BitNet بهعنوان یک راهکار نوآورانه در بهبود مدلهای زبانی بزرگ، با هدف کاهش مصرف انرژی و بهینهسازی منابع محاسباتی معرفی شده است. این معماری با جایگزینی وزنهای باینری (۱-بیتی) بهجای وزنهای با دقت بالا مانند FP16، توانسته است بهطور قابلتوجهی حجم محاسبات را کاهش داده و در عین حال، عملکردی مشابه با روشهای دقیقتر ارائه دهد. در این بخش، به جمعبندی مزایای BitNet و بررسی آینده آن در توسعه مدلهای زبانی و کاربردهای آتی میپردازیم.

۱. جمعبندی مزایا و ویژگیهای کلیدی BitNet

معماری BitNet با کاهش مصرف انرژی، بهینهسازی مصرف حافظه و کاهش هزینههای محاسباتی، بهعنوان یک گزینه موثر برای پیادهسازی مدلهای زبانی بزرگ مطرح است. آزمایشها نشان دادهاند که این معماری میتواند عملکردی مشابه با مدلهای FP16 داشته باشد، در حالی که مصرف انرژی کمتری دارد. BitNet همچنین در مقایسه با روشهای کوانتیزاسیون پساتربیتی، دقت بهتری ارائه میدهد و میتواند در وظایف مختلف زبانی عملکرد مطلوبی داشته باشد.

۲. چالشها و محدودیتهای احتمالی

اگرچه BitNet مزایای بسیاری دارد، اما چالشهایی نیز در پیادهسازی آن وجود دارد. یکی از چالشهای اصلی، مدیریت پایداری در آموزش مدلهای بزرگ و اطمینان از همگرایی مناسب در شرایط مختلف است. استفاده از وزنهای باینری ممکن است در برخی موارد به دقت پایینتری منجر شود، بهویژه در مدلهایی که نیاز به دقت بالاتری دارند. از این رو، بهبود روشهای کوانتیزاسیون و توسعه تکنیکهای بهینهسازی میتواند به رفع این چالشها کمک کند.

۳. کاربردهای آینده و توسعه BitNet

BitNet دارای پتانسیل بالایی برای گسترش به مدلهای بزرگتر و پیچیدهتر است. با توجه به نتایج آزمایشها، این معماری میتواند بهطور موثری برای مدلهایی با ابعاد بزرگتر به کار گرفته شود و همچنان به بهینهسازی منابع ادامه دهد. علاوه بر این، BitNet میتواند در کاربردهای مختلف هوش مصنوعی، از جمله پردازش زبان طبیعی، ترجمه ماشینی، و حتی سیستمهای توصیهگر، مورد استفاده قرار گیرد.

توسعه آینده BitNet میتواند شامل بهبود روشهای آموزش آگاه از کوانتیزاسیون، افزایش دقت در وزنهای باینری و استفاده از تکنیکهای ترکیبی مانند کوانتیزاسیون چندبیتی برای بخشهای مختلف مدل باشد. این رویکردها میتوانند به بهبود دقت و افزایش عملکرد BitNet کمک کنند و امکان استفاده از آن در کاربردهای حساستر را فراهم سازند.

۴. پتانسیل BitNet برای پیادهسازی در دستگاههای کممصرف

با توجه به کاهش مصرف انرژی و منابع محاسباتی، BitNet بهعنوان یک گزینه مناسب برای پیادهسازی در دستگاههایی با منابع محدود مانند تلفنهای همراه و دستگاههای IoT مطرح است. این ویژگیها میتوانند به استفاده گستردهتر از مدلهای زبانی بزرگ در کاربردهای صنعتی و دستگاههای هوشمند منجر شوند. آینده BitNet میتواند شامل بهینهسازیهای بیشتری برای استفاده در دستگاههای کممصرف و پیادهسازی در سیستمهای توزیعشده باشد.