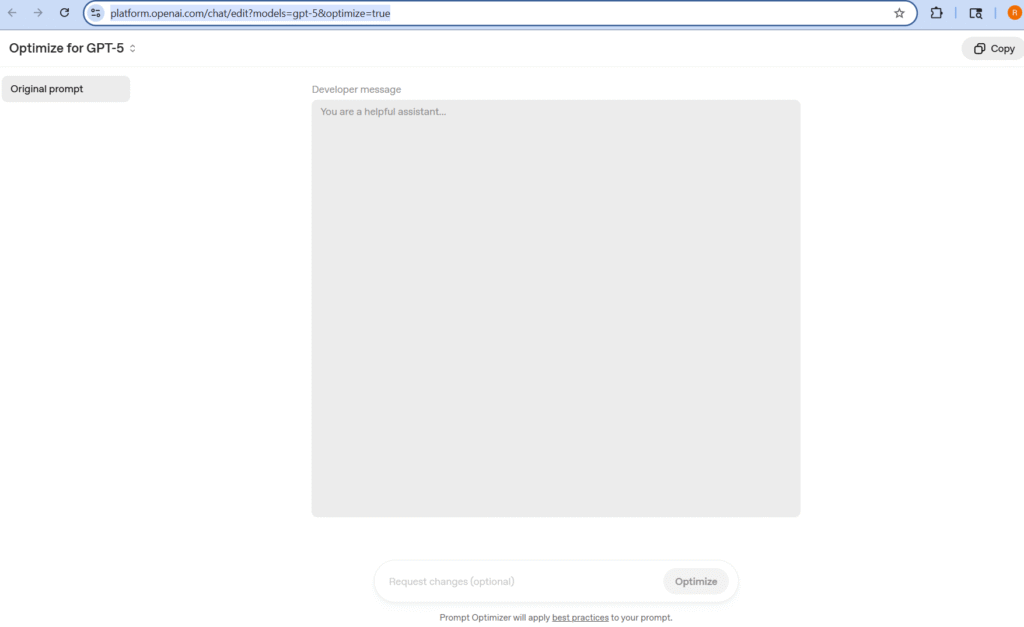

بهینهسازی پرامپتها در GPT-5 با استفاده از «Prompt Optimizer»

با معرفی خانواده مدلهای GPT-5، اوپناِیآی گام تازهای در تواناییهای مدلهای زبانی برداشته است. این نسل علاوه بر اینکه در استدلال و خلاقیت قویتر شده، در اجرای وظایف عاملمحور (Agentic Workflows)، کدنویسی و قابلیت هدایتپذیری (Steerability) نیز پیشرفت چشمگیری داشته است.

اما یک نکته مهم همچنان پابرجاست: کیفیت خروجی مدل تا حد زیادی به کیفیت پرامپت بستگی دارد.

برای رفع این چالش، اوپناِیآی ابزاری تازه به نام Prompt Optimizer در Playground معرفی کرده که به کاربران کمک میکند پرامپتهای قدیمی را به سادگی برای GPT-5 بهینه کرده و آنها را مطابق با بهترین شیوهها بازنویسی کنند.

چرا بهینهسازی پرامپت مهم است؟

بسیاری از پرامپتهایی که بهصورت دستی نوشته میشوند، دارای مشکلاتی از جمله:

- تناقض در دستورالعملها (مثلاً همزمان درخواست «سرعت» و «دقت مطلق»)

- مشخص نبودن قالب خروجی

- ناهماهنگی میان مثالهای ارائهشده و دستور پرامپت

میباشند. این موارد باعث میشود خروجی مدل بین چند حالت مختلف دچار نوسان شود.

کاربرد دقیق GPT-5 Prompt Optimizer چیست؟

این ابزار با بازنویسی هوشمند پرامپت:

- تناقضها و ابهامها را برطرف میکند.

- فرمت خروجی را دقیق مشخص میکند.

- شیوههای متناسب با وظیفه (مثل کدنویسی، تحلیل داده، یا پاسخ به پرسشهای متنی طولانی) را اعمال میکند.

- و در نهایت، پرامپت نهایی را به شکل یک Prompt Object ذخیره میکند تا در API و پروژههای مختلف قابل استفاده و نسخهبندی باشد.

نمونه کاربرد: بهینهسازی در کدنویسی

در یک آزمایش، از GPT-5 خواسته شد پایتونی بنویسد که پرکاربردترین واژهها را از یک متن بزرگ استخراج کند.

🔹 پرامپت اولیه ساده و دوستانه بود اما پر از تناقض:

- هم «یکبار پردازش در حافظه کم» را میخواست، هم «اجازه استفاده از حافظه بیشتر» میداد.

- هم «فقط از کتابخانه استاندارد» میخواست، هم «استفاده از کتابخانه خارجی در صورت نیاز» را مجاز میکرد.

نتیجه؟ مدل در خروجیهای مختلف، گاهی از کتابخانههای غیرضروری استفاده میکرد و گاهی حافظه زیادی مصرف میشد.

🔹 اما پس از بهینهسازی با Prompt Optimizer، پرامپت بازنویسی شد:

- الزام به تکعبوری بودن پردازش

- ممنوعیت کتابخانههای اضافی

- مشخصکردن دقیق قواعد توکنسازی و مرتبسازی

📊 نتایج:

- زمان اجرا کاهش یافت.

- مصرف حافظه بهطور چشمگیر کم شد.

- کیفیت کد (بر اساس داوری LLM-as-a-Judge) ارتقا پیدا کرد.

نمونه دوم: پرسشوپاسخ در متون مالی

در تست FailSafeQA (یک بنچمارک برای پرسشوپاسخ مقاوم در شرایط نویزی و ناقص)، پرامپت اولیه فقط به مدل میگفت: «تنها با استفاده از متن پاسخ بده.»

اما پرامپت بهینهشده:

- اولویتها را به ترتیب تعریف کرد (استناد به متن، بررسی شواهد، مقاومت در برابر نویز، و سیاست امتناع).

- قالب خروجی استاندارد ارائه داد.

- و خطمشی روشن برای پاسخندادن در صورت نبود اطلاعات داشت.

📊 نتایج FailSafeQA نشان داد که:

- استحکام پاسخها از ۰.۳۲ به ۰.۵۴ ارتقا یافت.

- درصد پاسخهای مستند به متن از ۰.۸۰ به ۰.۹۵ افزایش پیدا کرد.

جمعبندی

اگرچه GPT-5 ذاتاً قدرتمند است، اما پرامپت بهینه تفاوت زیادی ایجاد میکند.

Prompt Optimizer کمک میکند:

- نتایج پایدارتر شوند.

- مدل دقیقتر به محدودیتها پایبند بماند.

- خروجیها شفافتر، سریعتر و باکیفیتتر تولید شوند.

🔗 نتیجه روشن است: برای بهرهبرداری واقعی از توان GPT-5، بهینهسازی پرامپت نه یک گزینه جانبی، بلکه یک ضرورت است.

منبع : cookbook.openai.com